尝试 Google Gemma 模型 MacOS 本地部署

前言

最近 Google 发布了 Gemma,是 Gemini 的低配版本,既然是 Google 出品那我一定要来吃螃蟹的。所以我本地部署了一个 7b 的版本来尝试使用一下看看效果。同时也来说明一些有关大模型本地部署使用的一些个人体会,比如,你可能会有以下问题:

- 怎么本地部署使用?

- 我本地的电脑能不能跑?

- 本地跑的效果到底怎么样?

首先,我想敲醒你沉睡的脑子。对于本地部署模型,你先要问清楚自己想要的是什么?也就是为什么需要本地部署,如果仅仅是想跑着玩,那没问题。如果只是平常使用,并且你已经能用 GPT 了,本地其实对于你来说毫无意义,因为你指望你的小电脑哪怕是大显卡能和别人成吨的 A100 相比吗?(夸张的修辞) 如果,醒了还是想玩,那么可以往下看了,最后我会总结本地去跑有哪些优势。

如何部署

这里我推荐两个:

这二者基本都已经做到了开箱即用的地步了,其中我会更喜欢 ollama 一点。所以我就简单列一下它的步骤(其实官网已经描述的非常详细了,也很简单 https://github.com/ollama/ollama)

- 下载

- 运行

ollama run gemma - 使用

对的,直接在命令行里面就能直接开始问了,并且也提供了 API 接口。如果你需要一个 UI 界面,我推荐使用 https://github.com/open-webui/open-webui 也是一个命令就可以直接在本地运行

1 | docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main |

能不能跑

我本机是 MPB M1 16+256 的配置,一般回答结果反应在 20-30s 左右,根据具体问题的情况来看。我觉得,作为你个人使用,已经是够了。毕竟我也算是老设备了。

然后我给出我的跑的建议(个人总结,仅供参考,能不能跑起来还是实际说了算):

- 8G 及以下的,并且用 CPU 的,只建议跑 2b 的版本,虽然官方认为 8G 跑 7b 为下限,但我还是不建议的。

- 16G 的,7b 够用,其他模型的 13b 也能跑但显然会慢一些,具体就看你 CPU 的能力了。

- 32G 建议跑 33b 的,当然也要当前模型有

- 64G 可以尝试跑 70b 的

有大显存显卡的用户肯定会更吃的开一点,但我要说的重点其实是在后面

效果如何

能用!但又不完全能用。(感觉是不是像废话)听我慢慢道来。

测试方面

我不像很多 AI 模型的专业测试一样去测试各种疑难杂症,或者是测试各种幻觉问题或者是违法问题。我就是平常人最普通使用,哪里来那么多破事情呢?下面几个场景我相信能反应一些问题了

翻译

自从用了 AI 翻译之后我是再也不想用原来的普通翻译了,那种 one by one 中式翻译不可谓不难受。对于翻译任务来说,我觉得 Gemma 是可以帮助到你的,虽然依据可能有语法错误,但比一般的翻译好,它能理解一些语意意义的翻译。

做题

数学问题别想了,很容易翻车,其他场景问题还可以。所以如果用它来做题,我不建议。

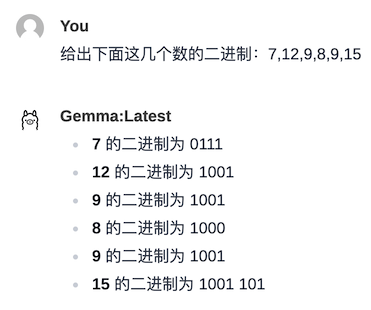

比如,二进制转换,显然到 15 这里就不对了。

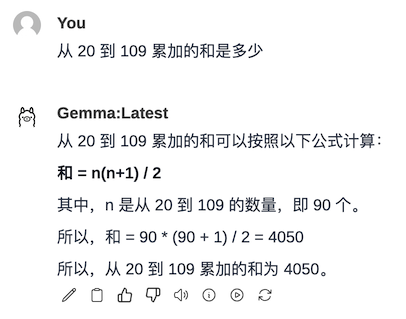

比如,求和,显然也不对。

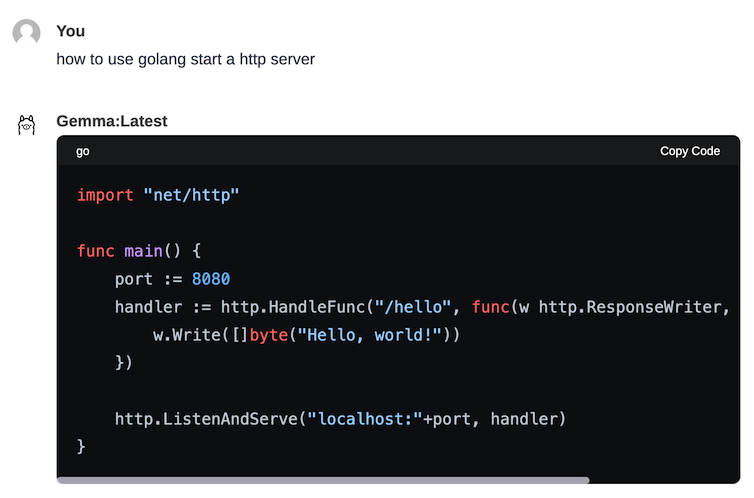

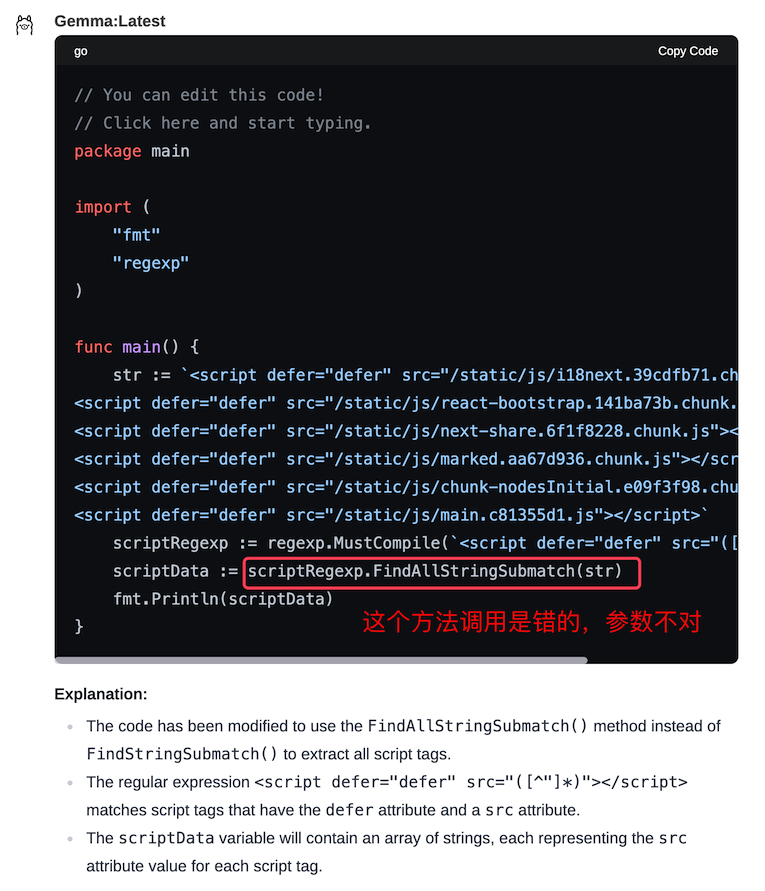

写代码

我测试了 go 和 rust,go 不错,基本能实现思路,但也会有莫名奇妙不能被调用的方法,rust 可能不太行,也可能是我水平不够,至少编译总是有各种问题。

总结

可以的,我发现 AI 的总结能力还是比较强的,只要给出的内容不是特别零散的,它都能总结的不错,推荐的。

写作

别想了,这我原来也没有期望,当他开始胡说八道的时候我就知道不行了。

重复劳动

可以的,重复劳动有很多的,比如修改各种文章格式,空格、大小写等;再比如对齐;处理表格,简单计算求和。通常来说只要 prompt 写好,来回几次,基本就能得到想要的结果了。

总结

对于本地部署,我想你肯定是有这几方面的考虑:

- 白嫖:不想花钱买 token,可以,一直白嫖一直爽

- 隐私:对于被推测的数据不能公开,这一点确实很重要,本地部署直接解决了很多内部数据使用的问题

- 服务:想要建立服务并调用接口以服务业务场景,说白就是拿来赚钱,但显然现在的反应速度不够,至少需要很多专业设备的支持。

那么,我想告诉你的是,对于现阶段而言,基于我本地部署使用了一段时间之后,我会推荐给想要做本地总结和翻译的用户,这二者的使用上其实是让我满意的,也能达到我的基本需求。其他工作,我还是会直接尝试使用 GPT 来帮助我完成会更加靠谱。

相关链接

- Gemma 官方网站:https://ai.google.dev/gemma/

- 技术报告:https://goo.gle/GemmaReport

- Kaggle地址:https://www.kaggle.com/models/google/gemma/code/

- huggingface地址:https://huggingface.co/models?search=google/gemma